核函数/kernel function

标签:机器学习基础知识目录

1. 核函数是什么

- 官方定义

设X是输入空间(欧式空间或者离散集合),H为特征空间(希尔伯特空间),如果存在一个从X到H的映射 \(\varphi (x):X\rightarrow H\) 使得对所有的\(x,y\in X\),函数\(K(x, y)=\varphi (x)\cdot \varphi (y)\),则称\(K(x,y)\)为核函数,\(\varphi (x)\)为映射函数,\(\varphi (x)\cdot \varphi (y)\)为x,y映射到特征空间上的内积

常见的空间有欧式空间、集合(离散)、赋范空间、希尔伯特空间

欧式空间:平常可见的1,2, … n维且满足可度量条件的空间,满足欧式五大公理

赋范空间:通俗理解为距离+线性结构+范数

希尔伯特空间:范赋空间+内积运算+完备性

距离定义:对任意非空集合X,对X中任意两点x, y满足d(x, y)<=0,当且仅当d(x, y)=0或者x=y; d(x, y)=d(y, x); d(x, y)<=d(x, z)+d(z, y)

线性结构:能够加减乘除,满足交换律、结合律

范数:空间点到空间零点的距离

内积运算:引入空间角的概念

完备性:内包含任意极限(通俗理解即永远逃不出的空间体系)

- 总结定义

核函数是一种满足Mercer’s condition(梅歇尔条件)的函数,包含映射、内积、相似度的逻辑,但具体的逻辑不要显示表征出来。这里不能说核函数是一种映射的原因是,映射指的是有限维度的关系变换,而核函数理论上可以推广到无限维度

Mercer’s condition是指,函数需满足对称性和正定性,所谓的对称性就是比如上述定义中 φ(x)∙φ(y)= φ(y)∙φ(x), 而所谓的正定性定义如下(核函数会对应Gram矩阵),当矩阵M所有的特征值大于零的前提下,根据谱定理,必然存在一个对角矩阵D与M相似(M = P-1DP),通俗的理解就是点M落在以P-1,P 为基的空间中,其特征值M就是在这组基空间下的具体点值

2. 核函数的作用

在机器学习领域,常用核函数来做特征映射,或者为特征变换。其深层原理是通过变换特征空间并在特征空间中组合有限的平滑函数对求解问题进行优化(所有的平滑函数都能通过麦克劳林展开式近似计算,从而为映射到无穷维度提供可能)

核函数映射到维空间,仅仅是增加了数据可分性,并不是代表一定可分

3. 常用的核函数有哪些

- 线性核

- 多项式核

- sigmoid核

- Radial basis function

4. 实际举例

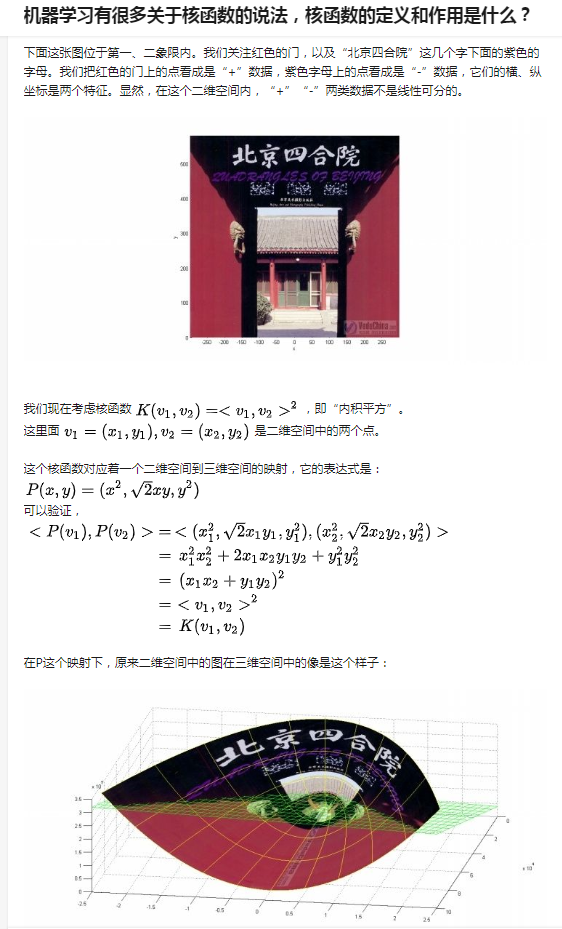

这里参考知乎大神王赟举的一个例子 北京四合院示例

这个示例用的核函数是多项式核,\(\gamma =1,c=0,n=2\)

原创文章,转载请注明出处!

本文链接:https://leo4678.github.io/posts/ml-kernel-function.html